09.10.2023 18:14

Вдосконалення мовних моделей за допомогою підказок до аналогій для покращення міркувань

Останніми роками мовні моделі продемонстрували вражаючі навички розуміння та генерування тексту, подібного до людського. Однак, незважаючи на їхні чудові мовні можливості, ці моделі часто відстають у складних міркувальних завданнях. Незалежно від того, чи йдеться про розв’язання математичних задач, генерування коду або виведення логічних висновків, традиційні мовні моделі стикаються зі значними труднощами в цих сферах. У відповідь на це обмеження команда дослідників з Google Deepmind і Стенфордського університету представила інноваційну техніку, відому як “Аналогічна підказка”, щоб покращити міркування мовних моделей. У цій статті досліджується проблема, запропоноване рішення, технологія, що лежить в основі Analogical Prompting, та її наслідки для майбутнього міркувань, керованих штучним інтелектом.

Мовні моделі, такі як GPT-3.5-turbo, досягли значного прогресу в розумінні природної мови та генерації тексту. Вони чудово справляються з такими завданнями, як переклад, генерація тексту і навіть відповіді на фактичні запитання. Однак, коли справа доходить до завдань, що вимагають глибоких міркувань, ці моделі часто потребують допомоги. Розглянемо наступний сценарій:

Студенту потрібна допомога з математичною задачею, яка передбачає знаходження добутку елементів у складових масиву. Хоча мовні моделі можуть зрозуміти постановку задачі, надання правильного розв’язку вимагає глибших міркувань, зокрема, залучення “алгоритму префіксного добутку”. Звичайні підказки можуть не допомогти моделі ефективно вирішити цю проблему.

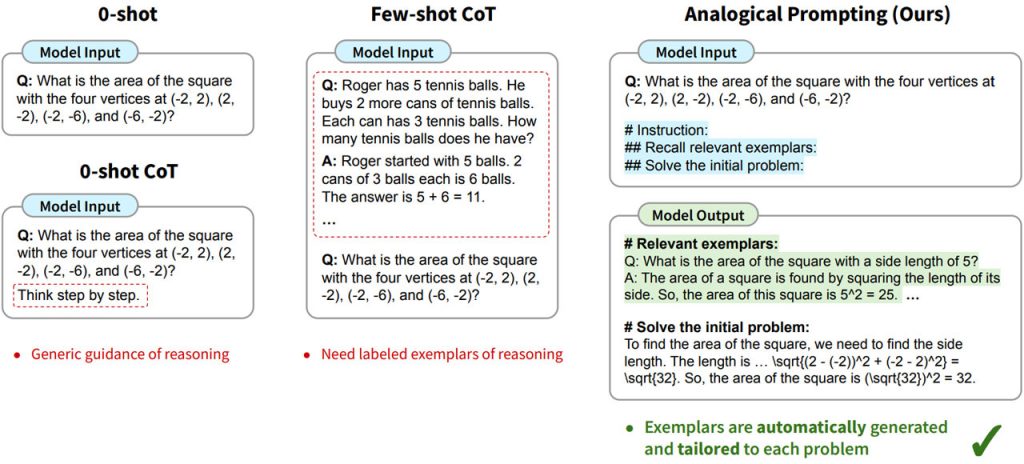

Перш ніж заглиблюватися в аналогічну підказку, важливо зрозуміти сучасні методи та їхні обмеження у вирішенні завдань на міркування. Дослідники вивчали такі методи, як підказка без підказок (zero-shot) та підказка з кількома підказками (few-shot CoT). Ці методи пропонують заздалегідь визначені приклади або підказки, щоб допомогти мовним моделям у виконанні завдань на міркування.

Однак ці методи мають свої недоліки. Вони часто вимагають значної кількості маркованих даних, які може бути складно отримати в різних галузях і мовах. Крім того, заздалегідь визначені приклади не завжди можуть ідеально відповідати проблемі, що призводить до неоптимальних результатів. Щоб подолати ці обмеження, дослідницька група запровадила аналогову підказку.

Аналогові підказки представляють собою зміну парадигми в тому, як мовні моделі підходять до завдань на міркування. Замість того, щоб покладатися на фіксовані підказки або заздалегідь визначені приклади, цей метод використовує генеративні можливості мовної моделі, щоб автономно створювати контекстно-релевантні приклади для кожної проблеми.

Уявіть собі аналогічну підказку як персоналізованого репетитора для мовних моделей. Коли модель стикається із завданням на міркування, вона генерує конкретні приклади, які безпосередньо пов’язані з контекстом і вимогами задачі. Наприклад, при вирішенні математичної задачі з використанням алгоритму префіксального добутку модель видає приклади, що демонструють застосування цього алгоритму.

Технологія Analogical Prompting ґрунтується на передових можливостях сучасних мовних моделей, таких як GPT-3.5-turbo. Ці моделі інтенсивно тренуються на великих наборах даних і володіють глибокими знаннями різних доменів і мов. Analogical Prompting використовує ці знання, щоб генерувати приклади для конкретних проблем.

Процес передбачає, що модель аналізує постановку задачі і, спираючись на свої широкі знання, створює відповідні приклади. Ці приклади допомагають моделі зрозуміти хитросплетіння проблеми та підійти до її вирішення з необхідною аргументацією. Analogical Prompting значно скорочує розрив між формулюванням проблеми та її розумінням моделлю.

Ефективність Analogical Prompting у завданнях на міркування є надзвичайно вражаючою. Експериментальні результати демонструють його перевагу над традиційними методами, такими як zero-shot і few-shot CoT, у різних областях. Зокрема, цей метод чудово справляється з завданнями на вирішення проблем, генерацією коду та логічними міркуваннями.

Одним з ключових висновків з аналогової підказки є її сумісність з великомасштабними мовними моделями. У поєднанні з просунутими моделями, такими як GPT-3.5-turbo, метод досягає чудових результатів. Згенеровані приклади надають значну перевагу, дозволяючи моделі ефективно вирішувати складні завдання.

Отже, Analogical Prompting — це новаторський підхід до покращення здатності мовних моделей до міркувань. Автономно генеруючи контекстуально релевантні приклади для кожної проблеми, цей метод долає розрив між формулюванням проблеми та її розумінням моделлю. Завдяки своїм багатообіцяючим результатам у різних галузях, Analogical Prompting дає змогу зазирнути в майбутнє міркувань, керованих штучним інтелектом.

)

)

)

)

)

)

)

)