21.12.2023 15:37

Новий інструмент для ефективного навчання ШІ з використанням масивних нейронних мереж

У сфері машинного навчання спостерігається тенденція до навчання більших мереж зі зростаючими параметрами, не зважаючи на те, що це вимагає надмірних витрат. Необхідність розуміння значення моделей з надмірними параметрами зберігається, враховуючи експоненціальне зростання витрат на навчання. У відповідь на це дослідники з Массачусетського університету Лоуелла, Eleuther AI та Amazon представили ReLoRA — метод, що використовує оновлення низького рангу для ефективного навчання мереж високого рангу.

Встановлення законів масштабування виявило потужну степеневу залежність між розміром мережі та її продуктивністю в різних умовах, що підтверджує ресурсоємний підхід до надмірної кількості параметрів. Для вирішення пов’язаних з цим проблем гіпотеза лотерейного квитка пропонує мінімізувати надмірну параметризацію. Методи точного налаштування низького рангу, такі як LoRA та Compacter, спрямовані на подолання обмежень, притаманних підходам матричної факторизації низького рангу.

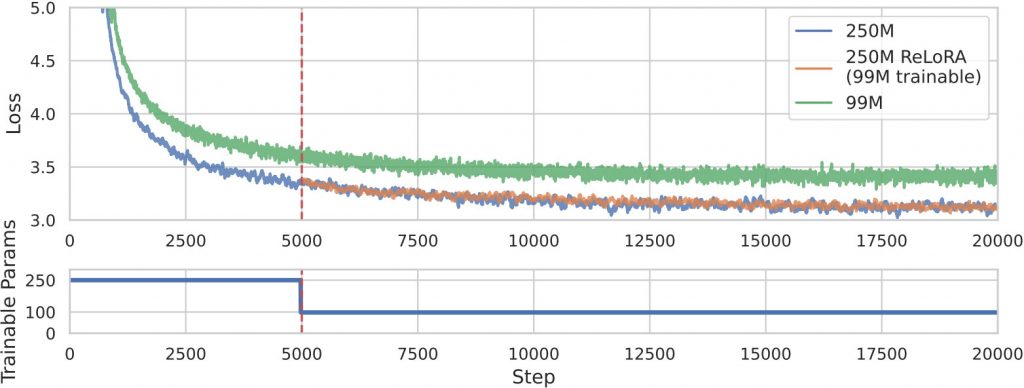

ReLoRA вирізняється тим, що застосовує свою техніку для навчання трансформаційних мовних моделей з 1,3 млрд параметрів, демонструючи продуктивність, порівнянну зі звичайним навчанням нейронних мереж. Використовуючи властивість рангу суми, ReLoRA виконує оновлення високого рангу за допомогою декількох низькорангових циклів. Метод включає тренування повного рангу з Gтеплим стартом», періодичне злиття параметрів в основну мережу, перезавантаження оптимізатора та повторне підвищення швидкості навчання. Використання оптимізатора Адама та планувальника косинусів ще більше підвищує ефективність ReLoRA.

На практиці ReLoRA демонструє паритетну продуктивність зі звичайним навчанням нейронних мереж як у попередніх, так і в кінцевих обчисленнях. Зокрема, вона забезпечує значну економію до 5,5 Гб графічної пам’яті на графічний процесор і прискорює швидкість навчання на 9-40%, залежно від розміру моделі та конфігурації апаратного забезпечення. Якісний аналіз спектру сингулярних значень показує, що ReLoRA має вищу масу розподілу між 0,1 та 1,0, що нагадує повнорангове навчання, на відміну від LoRA, де переважають нульові відмінні значення.

Таким чином, ReLoRA є ефективною за параметрами технікою навчання, що використовує оновлення низького рангу для ефективного навчання великих нейронних мереж. Його переваги включають значну економію пам’яті графічного процесора, підвищену швидкість навчання та перевагу над низькоранговою факторизацією матриць при навчанні високопродуктивних моделей трансформаторів.

)

)

)

)

)

)

)

)