07.09.2023 10:11

Нова мовна модель ШІ з відкритим вихідним кодом Falcon випередила Meta і Google

LLaMA 2 від Meta була витіснена нещодавно випущеною 180-мільярдною мовною моделлю Falcon Large Language Model.

Спільнота фахівців зі штучного інтелекту може пишатися новим досягненням – Falcon 180B, великою мовною моделлю (LLM) з відкритим вихідним кодом, яка може похвалитися 180 мільярдами параметрів, навченими на величезній кількості даних. Цей потужний новачок перевершив попередні LLM з відкритим вихідним кодом на кількох фронтах.

Falcon 180B, анонсована в блозі спільноти Hugging Face AI, була випущена на Hugging Face Hub. Архітектура новітньої моделі базується на попередній серії Falcon з відкритим вихідним кодом, використовуючи такі інновації, як багатозапитна увага, для масштабування до 180 мільярдів параметрів, навчених на 3,5 трильйонах токенів.

Це найдовше на сьогоднішній день попереднє навчання для моделі з відкритим вихідним кодом в рамках однієї епохи. Щоб досягти таких показників, було використано 4096 графічних процесорів одночасно протягом приблизно 7 мільйонів графічних годин, з використанням Amazon SageMaker для навчання та вдосконалення.

Щоб оцінити розмір Falcon 180B в перспективі, його параметри в 2,5 рази більші, ніж у моделі LLaMA 2 від Meta. LLaMA 2 раніше вважався найпотужнішим LLM з відкритим вихідним кодом після його запуску на початку цього року, маючи 70 мільярдів параметрів, навчених на 2 трильйонах токенів.

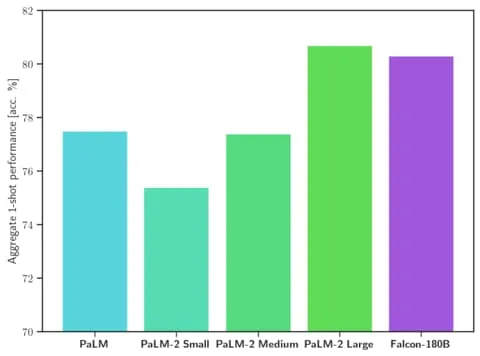

Falcon 180B перевершує LLaMA 2 та інші моделі як за масштабом, так і за продуктивністю в низці завдань з обробки природної мови (NLP). Він посідає перше місце в рейтингу моделей з відкритим доступом з 68,74 балами і досягає майже паритету з комерційними моделями, такими як PaLM-2 від Google, за такими оцінками, як бенчмарк HellaSwag.

Зокрема, Falcon 180B відповідає або навіть перевершує PaLM-2 Medium у широко використовуваних бенчмарках, включаючи HellaSwag, LAMBADA, WebQuestions, Winogrande та інші. Він практично на одному рівні з PaLM-2 Large від Google. Це надзвичайно висока продуктивність для моделі з відкритим вихідним кодом, навіть якщо порівнювати з рішеннями, розробленими гігантами індустрії.

Якщо порівнювати з ChatGPT, то модель потужніша за безкоштовну версію, але трохи поступається за можливостями платному сервісу «плюс».

«Falcon 180B зазвичай знаходиться десь між GPT 3.5 і GPT4 в залежності від оціночного бенчмарка, і за подальшим доопрацюванням спільноти буде дуже цікаво стежити тепер, коли вона відкрито випущена», – йдеться в блозі.

Випуск Falcon 180B являє собою останній стрибок вперед у стрімкому прогресі, який нещодавно був досягнутий з LLM. Окрім простого збільшення параметрів, такі методи, як LoRA, рандомізація ваги та Perfusion від Nvidia, дозволили значно підвищити ефективність навчання великих моделей ШІ.

Оскільки Falcon 180B зараз знаходиться у вільному доступі на Hugging Face, дослідники очікують, що модель отримає додаткові переваги завдяки подальшим вдосконаленням, розробленим спільнотою. Однак демонстрація передових можливостей природної мови з самого початку знаменує собою захоплюючу подію для ШІ з відкритим вихідним кодом.

)

)

)

)

)

)

)