10.09.2024 14:27

Нова модель OLMoE від AI2 має на меті бути одночасно потужною та економічно ефективною

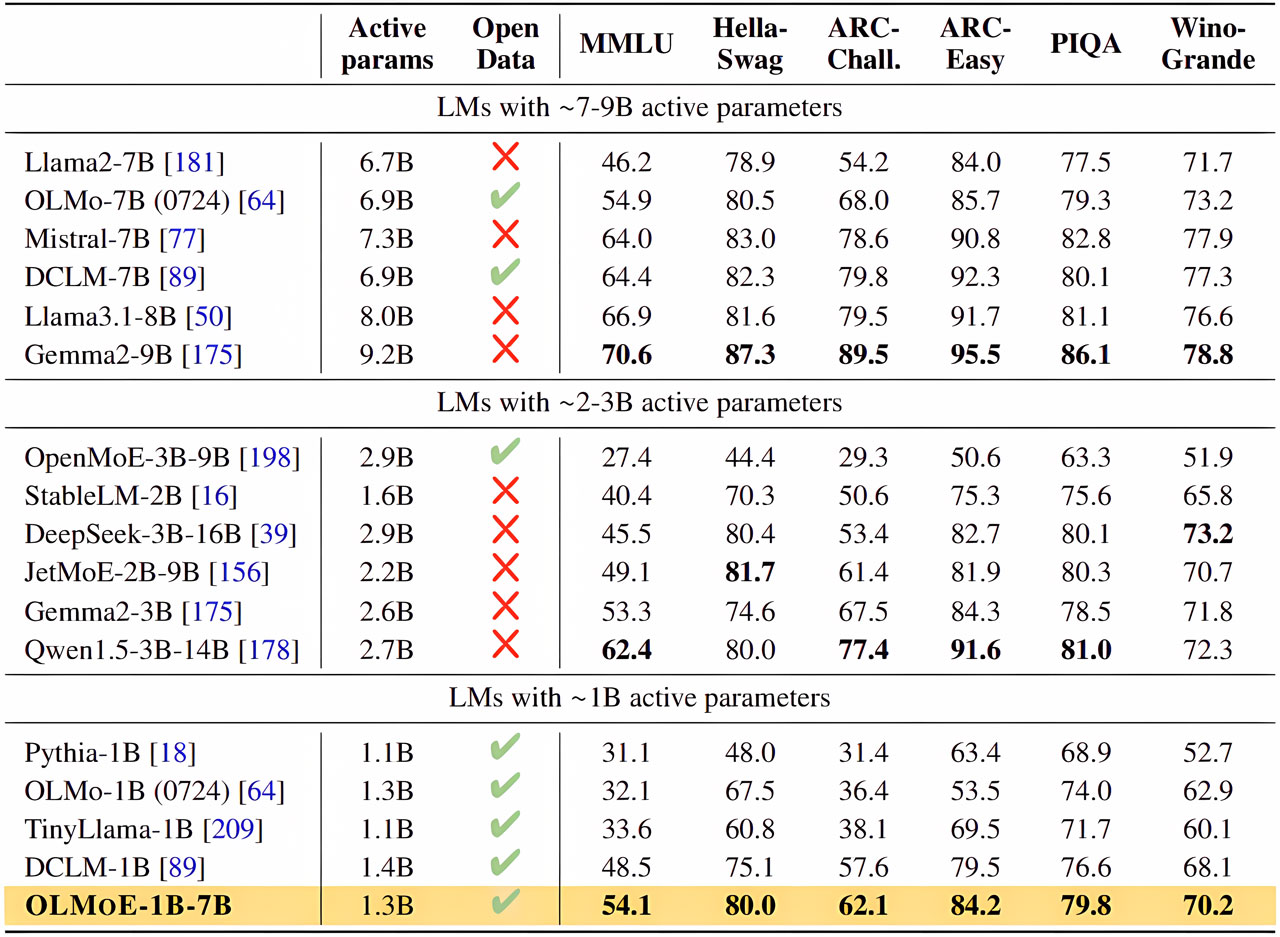

Інститут Аллена з досліджень штучного інтелекту (AI2) представив OLMoE — нову мовну модель з відкритим вихідним кодом, яка обіцяє високу продуктивність та економічну ефективність. OLMoE побудована на архітектурі розрідженої «комбінації експертів» (MoE), що дозволяє ефективно вирішувати складні завдання, активуючи лише підмножину загальних параметрів для кожного входу, що значно знижує обчислювальні вимоги. Така особливість моделі має ключове значення, оскільки, маючи загалом 7 мільярдів параметрів, OLMoE використовує лише 1 мільярд параметрів для кожного вхідного токена. Модель доступна у двох версіях: OLMoE-1B-7B для загального використання та OLMoE-1B-7B-Instruct, яка призначена для налаштовування.

Особливістю OLMoE в порівнянні з іншими моделями, які використовують подібну архітектуру MoE, є її структура з відкритим вихідним кодом. Хоча багато наявних моделей MoE оприлюднили деякі аспекти діяльності, наприклад, ваги моделей, їм часто бракує прозорості щодо обсягу навчальних даних, коду або методологій. OLMoE надає всі дані у відкритому доступі, роблячи їх доступними для академічних і дослідницьких спільнот, які зазвичай стикаються з перешкодами при роботі з моделями з обмеженими вихідними даними. Ця відкритість відповідає загальній меті AI2 щодо демократизації технології штучного інтелекту та забезпечення продуктивності, яка не обмежується лише пропрієтарними системами.

Архітектура моделі вирізняється застосуванням методу деталізованої маршрутизації. OLMoE одночасно активує лише 8 з 64 малих «експертів» для обробки вхідних даних, що допомагає підтримувати високу продуктивність, знижуючи при цьому витрати на пам’ять і обчислення. Це дозволяє OLMoE конкурувати з більшими моделями, але за меншу вартість. Наприклад, він перевершив інші моделі з аналогічними активними параметрами та навіть перевершив в деяких тестах більші моделі, такі як Llama2-13B-Chat і DeepSeekMoE-16B.

OLMoE побудована на основі попередньої моделі AI2, OLMo 1.7-7B, і використовує дані з навчального набору даних Dolma, поряд з іншими наборами даних, такими як Common Crawl і Project Gutenberg. Модель має повністю відкритий вихідний код, що є рідкістю серед моделей MoE, які переважно залишаються закритими, залишаючи дослідникам мало інформації про те, як вони функціонують і навчаються. Така прозорість має вирішальне значення для просування економічно ефективних відкритих моделей MoE та розвитку ШІ в цілому.

AI2 підкреслює, що відкритий код моделей MoE є дуже важливим, оскільки архітектура «комбінації експертів» додає нові складнощі. Розробники повинні визначити кількість параметрів, які потрібно активувати, наскільки великими мають бути окремі «експерти» і які алгоритми маршрутизації потрібно впроваджувати. Всі ці фактори мають значний вплив на ефективність та результативність моделі. Забезпечуючи максимальну прозорість, AI2 сподівається уможливити проведення подальших експериментів та вдосконалень у спільноті ШІ-спеціалістів.

)

)

)

)

)

)

)

)