13.12.2023 11:16

Mistral AI випустила Mixtral, відкриту велику мовну модель, яка перевершує GPT 3.5

Паризький стартап Mistral AI випустив Mixtral, відкриту велику мовну модель (LLM), яка, за його словами, перевершує GPT 3.5 від OpenAI в декількох тестах, бувши при цьому набагато ефективнішою.

Mixtral використовує техніку під назвою «розріджена суміш експертів» (sparse mixture of experts, MoE), яка дозволяє моделі бути більш потужною та ефективною, ніж її попередник, Mistral 7b, і навіть ніж її більш потужні конкуренти.

MoE — це метод машинного навчання, в якому розробники тренують або створюють кілька віртуальних експертних моделей для вирішення складних завдань. Кожна експертна модель навчається за певною темою або галуззю. Коли модель отримує завдання, вона обирає групу експертів з пулу агентів, і ці експерти використовують свою підготовку, щоб вирішити, який результат найкраще відповідає їхнім знанням.

Mixtral має 46,7 мільярда параметрів, але використовує лише 12,9 мільярда параметрів на токен. Це означає, що він обробляє вхідні дані та генерує вихідні з тією ж швидкістю і за тією ж вартістю, що і модель з 12,9 мільярдами параметрів.

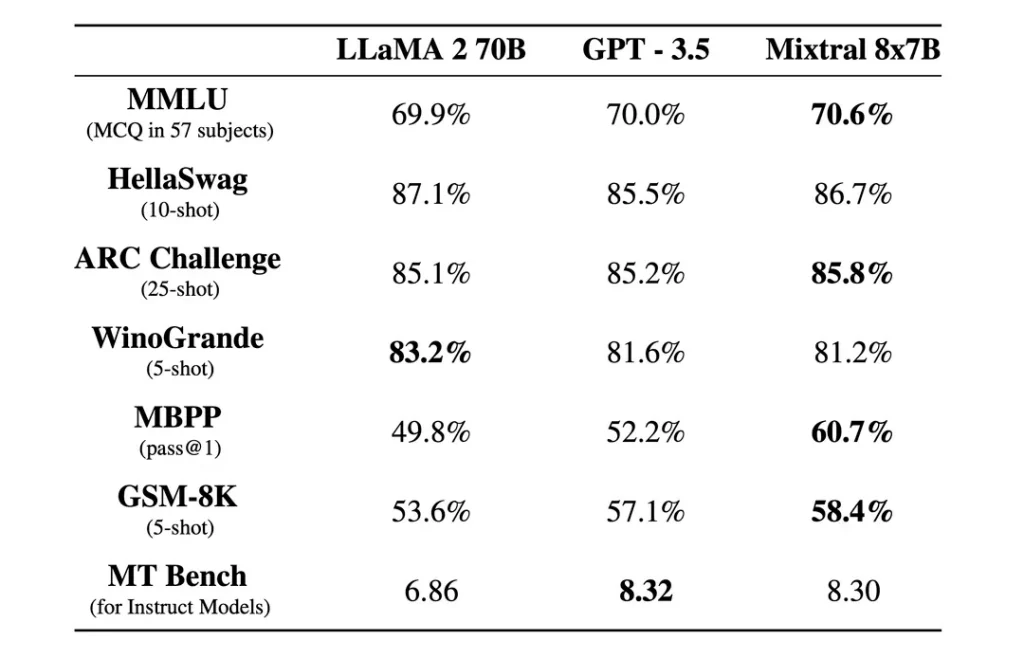

У тестах Mixtral перевершує Llama 2 70B на більшості бенчмарків з 6-кратно швидшим висновком. Це відповідає або перевершує GPT 3.5 на більшості стандартних бенчмарків.

Mixtral також ліцензований за дозвільною ліцензією Apache 2.0. Це дозволяє розробникам вільно перевіряти, запускати, модифікувати та навіть створювати власні рішення на основі моделі.

Компанія стверджує, що Mixtral був налаштований так, щоб працювати винятково добре іноземними мовами. Mixtral 8×7B володіє французькою, німецькою, іспанською, італійською та англійською мовами, отримавши високі бали в стандартизованих багатомовних тестах.

Також була випущена версія Mixtral 8×7B Instruct для ретельного дотримання інструкцій, яка отримала найвищий бал 8,3 в тесті MT-Bench. Це робить її наразі найкращою моделлю з відкритим вихідним кодом на цьому тесті.

Нова модель Mistral обіцяє революційну розріджену архітектуру, багатомовність і повний відкритий доступ. Це є важливим досягненням для спільноти відкритого коду, яка переживає захопливу і цікаву епоху.

Mixtral можна завантажити через Hugging Face, але користувачі також можуть скористатися онлайн-версією.

)

)

)

)

)

)

)