28.02.2024 17:14

Meta оприлюднює мультимодальний відкритий набір даних записаний за допомогою окулярів проєкту Aria Glasses

Поява доповненої реальності (AR) та гаджетів зі штучним інтелектом позначила значний стрибок вперед у взаємодії людини та машини. Ці технології дозволяють збирати дані новими способами, відкриваючи можливості для розробки висококонтекстуалізованих і персоналізованих помічників зі штучним інтелектом, які легко інтегруються з когнітивними процесами користувача.

Хоча існуючі мультимодальні ШІ-асистенти, такі як GPT-4v, Gemini і Llava, можуть інтегрувати контекст з різних джерел, їхнє розуміння обмежується свідомо введеними даними або загальнодоступним інтернет-контентом. Майбутні асистенти зі штучним інтелектом, однак, мають на меті отримати доступ до контекстної інформації, зібраної з діяльності користувача та його оточення, і це є серйозним технологічним викликом через потребу у величезних і різноманітних наборах даних для навчання таких складних моделей.

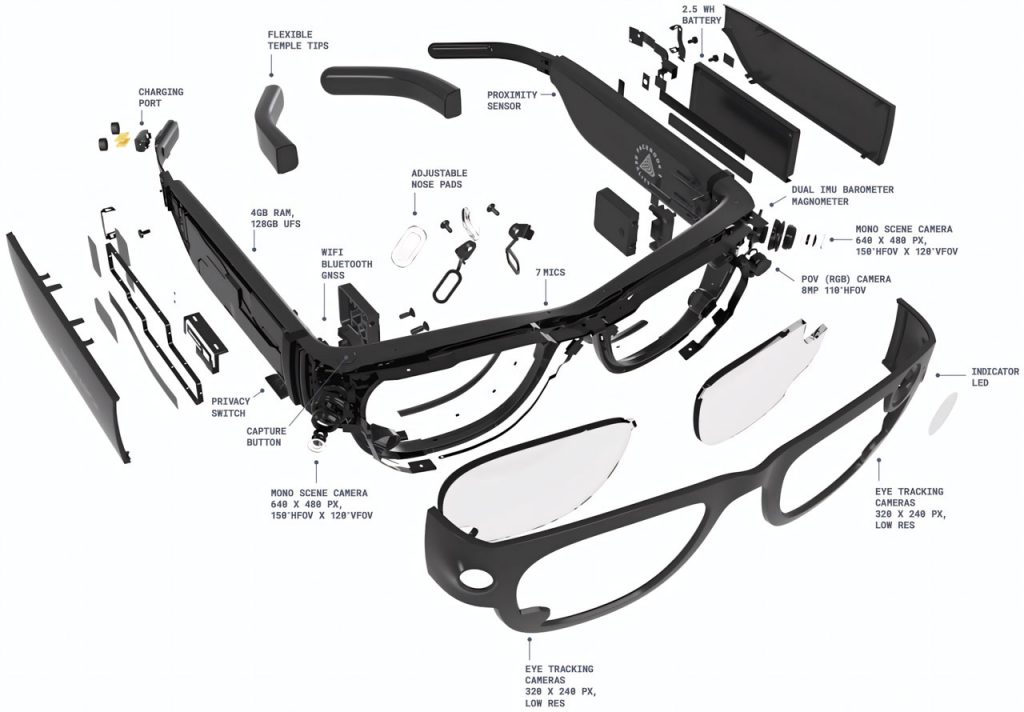

Звичайним наборам даних, в першу чергу з відеокамер, не вистачає мультимодальних сенсорних даних, необхідних для майбутніх пристроїв доповненої реальності. Їм бракує точного відстеження рухів, детального контексту навколишнього середовища та 3D-просторової інформації, що заважає зробити надійні висновки про поведінку або наміри користувача. Дослідники з Meta представили набір даних Aria Everyday Activities (AEA), записаний за допомогою потужної сенсорної платформи пристроїв Project Aria.

Набір даних AEA надає багате, мультимодальне, чотиривимірне уявлення про повсякденну діяльність з точки зору користувача. Він включає просторовий звук, відео високої чіткості, дані відстеження руху очей, інерційні вимірювання та багато іншого – все це вирівняно в загальній 3D-системі координат і синхронізовано в часі. Набір даних, що містить 143 послідовності щоденних дій, записаних у п’яти локаціях у приміщенні, пропонує багату егоцентричну мультимодальну інформацію, зібрану за допомогою сучасних окулярів Project Aria.

Доповнений обробленими даними від сервісів машинного сприйняття, набір даних AEA слугує псевдо-істиною для навчання та оцінки моделей ШІ. Дані мультимодальних сенсорів дають повне уявлення про навколишнє середовище та досвід користувача. Крім того, набір даних включає вирівняні в часі транскрипції голосу, 3D-вектори погляду очей, глобально вирівняні 3D-траєкторії і детальні хмари точок сцени, що збагачує його для досліджень і застосувань.

Дослідницькі програми, які стали можливими завдяки набору даних AEA, включають нейронну реконструкцію сцен і швидку сегментацію, що демонструє його потенціал для вдосконалення алгоритмів просторового розуміння і розпізнавання об’єктів. Загалом, набір даних щоденної активності Aria є значним доповненням до області егоцентричних мультимодальних наборів даних, прокладаючи шлях для подальшого розвитку портативних технологій доповненої реальності та штучного інтелекту.

)

)

)

)

)

)

)

)