26.03.2024 15:10

HuggingFace представив Quanto

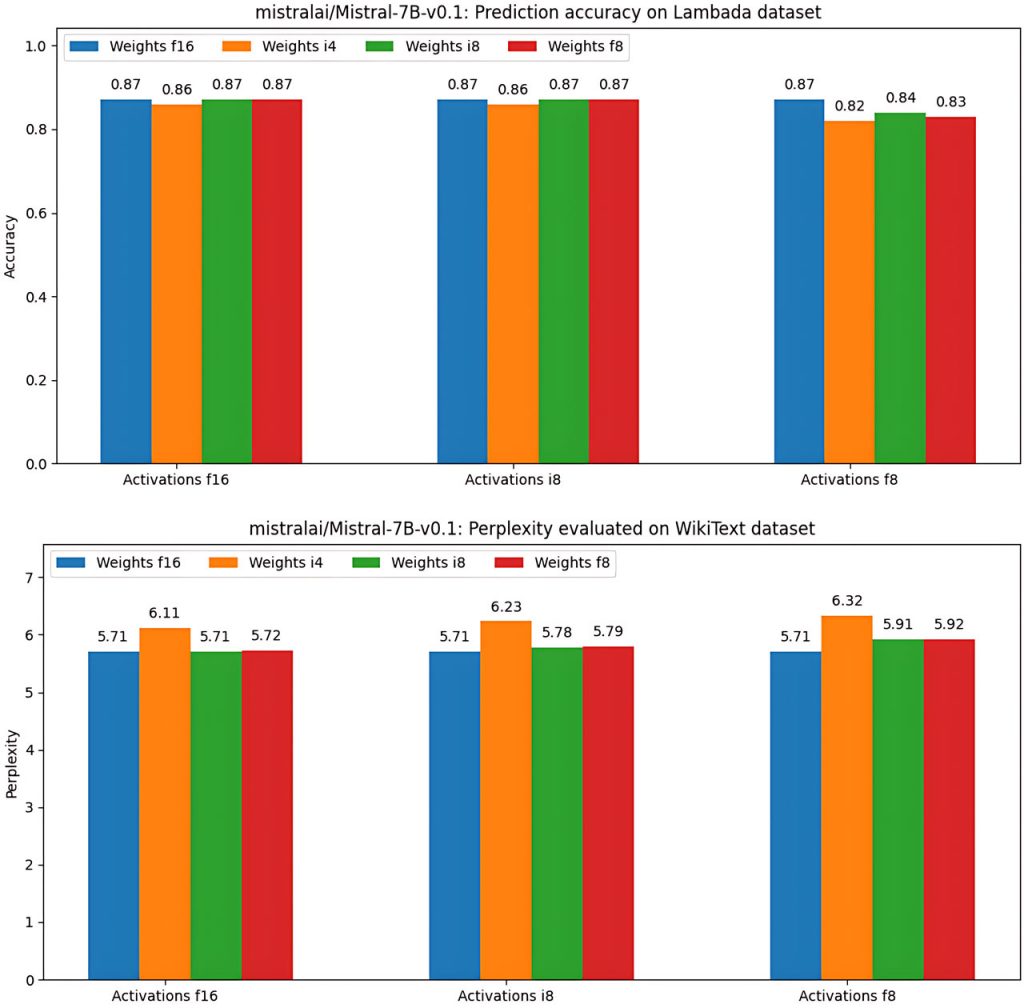

Дослідники HuggingFace представили Quanto, бібліотеку Python, призначену для вирішення проблеми оптимізації моделей глибокого навчання для розгортання на пристроях з обмеженими ресурсами, таких як мобільні телефони та вбудовані системи. Основна увага Quanto зосереджена на зменшенні витрат на обчислення та пам’ять при оцінюванні великих мовних моделей на портативних пристроях, забезпечуючи ефективне використання обмежених ресурсів.

Quanto використовує низькоточні типи даних, такі як 8-розрядні цілі числа (int8) замість стандартних 32-розрядних чисел з плаваючою комою (float32) для представлення ваг та активацій у моделях глибокого навчання. Завдяки цьому значно зменшується навантаження на обчислення та пам’ять, що робить можливим розгортання складних моделей на пристроях з обмеженими ресурсами.

Однією з ключових переваг Quanto є його простота і зручність використання. Він надає простий інтерфейс прикладного програмування для квантування моделей PyTorch, пропонуючи можливості, що виходять за рамки вбудованих інструментів квантування PyTorch. Quanto підтримує квантування в режимі очікування та розгортання на різних пристроях, включаючи CUDA та MPS. Він автоматизує такі завдання, як вставка кроків квантування та деквантифікації у робочий процес моделі, обробка функціональних операцій та квантування певних модулів.

Quanto не робить чіткої різниці між динамічним і статичним квантуванням, дозволяючи користувачам динамічно квантувати моделі за замовчуванням з можливістю заморозити ваги у вигляді цілих значень пізніше. Такий оптимізований підхід спрощує процес квантування і зменшує ручні зусилля.

Крім того, Quanto підтримує декілька типів даних для квантування, включаючи ваги та активації int8, а також int2, int4 і float8, що забезпечує гнучкість процесу квантування. Інтеграція з бібліотекою Hugging Face Transformers дозволяє безперешкодно квантувати моделі трансформаторів, що ще більше розширює її корисність і застосовність.

Попередні результати показують багатообіцяюче зменшення розміру моделі та збільшення швидкості виведення, що робить Quanto цінним інструментом для оптимізації моделей глибокого навчання для розгортання на пристроях з обмеженими ресурсами. В цілому, Quanto пропонує універсальний і зручний інструментарій квантування PyTorch, який вирішує проблеми розгортання моделей глибокого навчання в середовищах з обмеженими ресурсами.

)

)

)

)

)

)

)

)