11.09.2023 12:28

Falcon 180B: найбільша відкрита мовна модель зі 180 мільярдами параметрів

Попит на потужні та універсальні мовні моделі, які здатні працювати у сферах обробки природної мови та штучного інтелекту, постійно зростає. Ці моделі лежать в основі безлічі додатків, від чат-ботів і віртуальних асистентів до машинного перекладу та аналізу емоційного настрою. Однак проблема полягає у створенні мовних моделей, які можуть успішно виконувати різні мовні завдання, і цю проблему нещодавно було вирішено завдяки новаторському рішенню.

У прагненні створити вдосконалені мовні моделі дослідники зіткнулися з обмеженнями, пов’язаними з розміром моделі, навчальними даними та універсальністю. Це призвело до фрагментарного ландшафту, де різні моделі блищать у вирішенні конкретних завдань, але мало хто з них може претендувати на універсальне рішення.

Дослідники з Інституту технологічних інновацій (Technology Innovation Institute, TII) презентували мовну модель, що змінює правила гри: Falcon 180B. Велика мовна модель Falcon 180B являє собою значний стрибок уперед, адже вона має приголомшливі 180 мільярдів параметрів. Від своїх попередників і конкурентів він відрізняється не лише розмірами, але й універсальністю та доступністю. На відміну від багатьох моделей з закритим вихідним кодом, які залишаються приватною власністю, Falcon 180B розроблений таким чином, щоб бути доступним як для дослідницького, так і для комерційного використання. Цей перехід до відкритого доступу відповідає ширшій тенденції у спільноті ШІ, де прозорість і співпраця стають дедалі ціннішими.

Чудові можливості Falcon 180B є результатом його тривалого навчання на різноманітному наборі даних, що містить колосальні 3,5 трильйона токенів. Цей величезний масив тексту забезпечує моделі безпрецедентне розуміння мови та контексту, що дозволяє їй досягати успіху в широкому спектрі завдань з обробки природної мови.

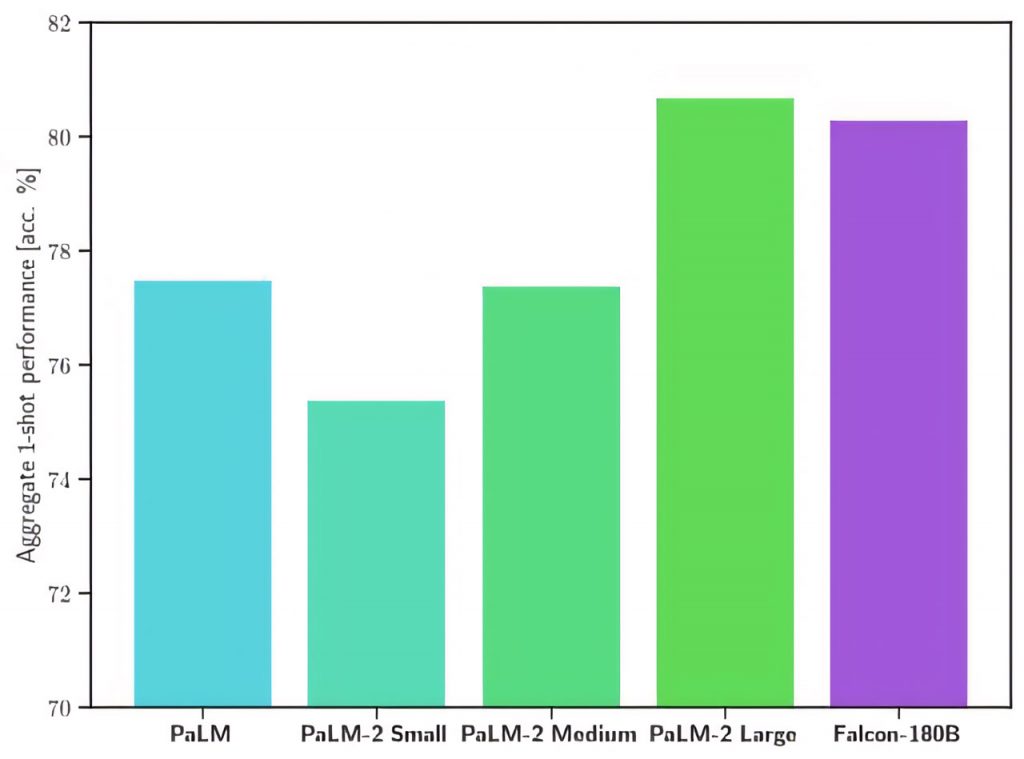

Однією з визначних особливостей моделі є її здатність вирішувати різноманітні мовні завдання, включаючи міркування, кодування, оцінювання рівня володіння мовою та тестування знань. Така універсальність є свідченням навчання на багатому і різноманітному наборі даних, що включає веб-дані, розмови, технічні документи і навіть частину коду. Продуктивність Falcon 180B у цих завданнях часто перевершує продуктивність конкурентів з закритим вихідним кодом, таких як LLaMA 2 від Meta.

Зокрема, Falcon 180B посідає гідне місце в рейтингу Hugging Face Leaderboard з результатом 68,74 бала. Ця позиція в рейтингу лідерів зміцнює позиції Falcon 180B як лінгвістичної моделі найвищого рівня, добре оснащеної для вирішення різноманітних завдань, пов’язаних з лінгвістикою.

Отже, Falcon 180B від TII є значним досягненням в обробці природної мови. Його розмір, навчальні дані та наявність відкритого доступу роблять його потужним і універсальним інструментом для дослідників і розробників. Рішення надати відкритий доступ до Falcon 180B заслуговує на особливу увагу, оскільки воно відповідає зростаючій важливості прозорості та співпраці у спільноті ШІ.

Наслідки впровадження Falcon 180B є глибокими. Пропонуючи модель з відкритим доступом зі 180 мільярдами параметрів, TII дає можливість дослідникам і розробникам досліджувати нові межі в обробці природної мови. Порівняно з аналогами з закритим кодом, конкурентна продуктивність цієї моделі відкриває двері для інновацій у різних галузях, включаючи охорону здоров’я, фінанси, освіту тощо.

Крім того, успіх Falcon 180B підкреслює цінність ініціатив з відкритим кодом у галузі ШІ. Він демонструє, що коли дослідники надають пріоритет співпраці та доступності, прориви в галузі ШІ стають доступними для ширшої аудиторії. Оскільки спільнота ШІ продовжує розвиватися і впроваджувати принципи відкритого коду, Falcon 180B слугує яскравим прикладом того, чого можна досягти завдяки прозорості, співпраці та прагненню розширювати межі можливостей ШІ. Завдяки Falcon 180B і подібним ініціативам майбутнє штучного інтелекту виглядає багатообіцяючим, інклюзивним і спільним, що в кінцевому підсумку принесе користь суспільству в цілому.

)

)

)

)

)

)

)

)