26.10.2023 10:01

Дослідники з Китаю розробили механізм корекції галюцинацій для моделей штучного інтелекту

Команда вчених з Китайського науково-технічного університету та лабораторії YouTu Lab компанії Tencent розробила інструмент, який може допомогти моделям штучного інтелекту (ШІ) уникати генерування неправдивої інформації, відомої як «галюцинації».

Галюцинації — це схильність ШІ-моделей генерувати результати, які не ґрунтуються на інформації, що міститься в їх навчальних даних. Ця проблема пронизує дослідження великих мовних моделей (LLM), і її наслідки можна побачити в таких моделях, як ChatGPT від OpenAI та Claude від Anthropic.

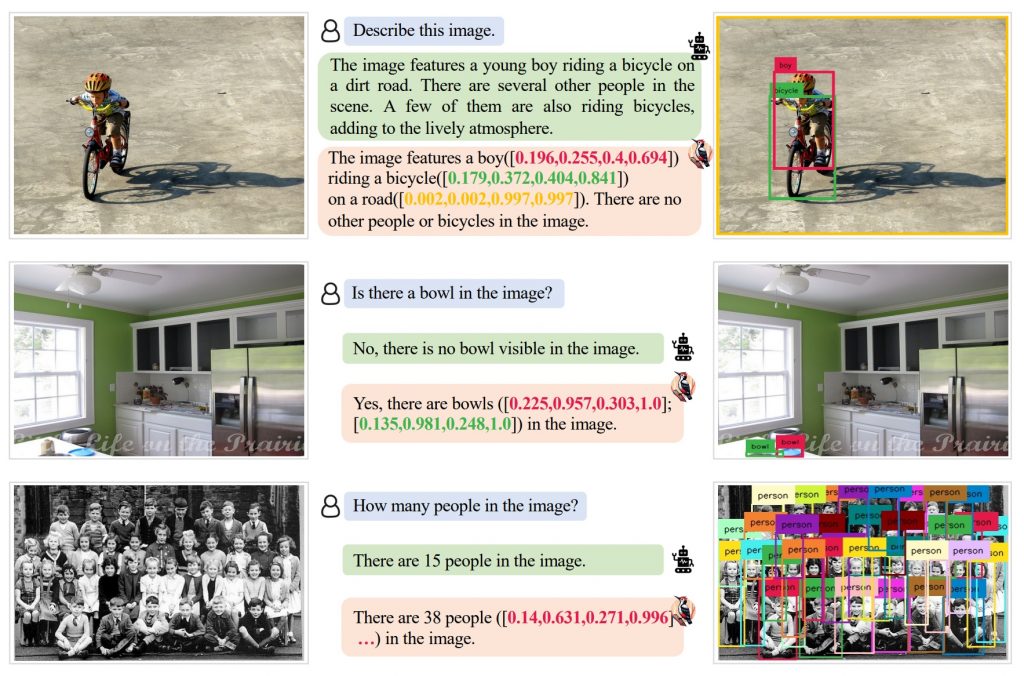

Інструмент, який команда назвала «Woodpecker», використовує три окремі моделі ШІ для виявлення та виправлення галюцинацій у MLLM. Ці моделі, GPT-3.5 turbo, Grounding DINO і BLIP-2-FlanT5, працюють разом, щоб оцінити вихід MLLM і визначити, чи є він галюцинацією. Якщо так, то Woodpecker дає вказівки MLLM регенерувати свій вихід відповідно до отриманих даних.

Для виправлення галюцинацій ШІ-моделі Woodpecker використовують п’ятиступеневий процес, який включає:

- Вилучення ключових понять з генерованого тексту.

- Формулювання запитань про ці ключові поняття.

- Візуальна перевірка знань для отримання відповідей на запитання.

- Візуальна генерація тверджень, які відповідають отриманим відповідям.

- Виправлення генерованого тексту відповідно до візуальних тверджень.

Дослідники стверджують, що їхній метод забезпечує додаткову прозорість і «підвищення точності на 30,66%/24,33% порівняно з базовим MiniGPT-4/mPLUG-Owl». Вони оцінили численні «готові» MLLM за допомогою свого методу і дійшли висновку, що Woodpecker може бути «легко інтегрований в інші MLLM».

)

)

)

)

)

)

)