29.02.2024 10:30

Компанія SambaNova представила модель «Composition of Experts» з 1 трильйоном параметрів для ШІ в корпоративному сегменті

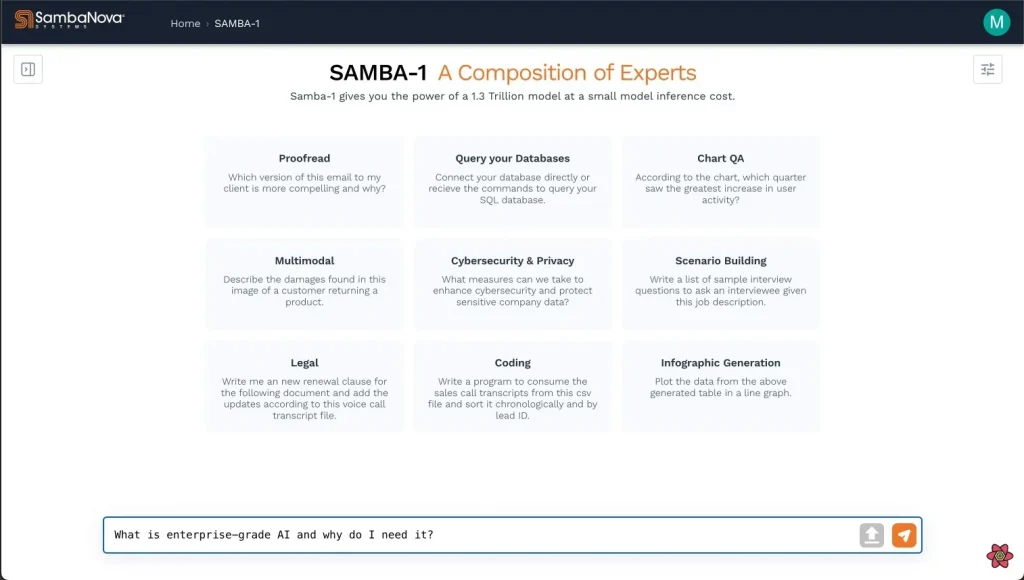

SambaNova Systems оголосила про випуск однієї з найбільших мовних моделей (LLM) у світі — моделі Samba-1 з 1 трильйоном параметрів.

Модель Samba-1 — це не просто одна модель, як, наприклад, GPT-4 від OpenAI. Це комбінація понад 50 високоякісних моделей штучного інтелекту, які об’єднані в рамках підходу, що отримав назву «Composition of Experts». Попри величезний розмір, модель Samba-1 може легко налаштовуватися для різних випадків використання в корпоративному секторі.

Компанія SambaNova Systems не лише розробляє великі мовні моделі, але та активно працює над апаратним забезпеченням. У вересні компанія анонсувала випуск свого ШІ-чіпу SN40L, який призначений для конкуренції з лідером галузі Nvidia завдяки своєму високоефективному підходу до навчання та виведення результатів. Нова модель Samba-1 буде включена до SambaNova Suite, що дозволить підприємствам налаштовувати та розгортати моделі.

Родріго Лян, співзасновник і генеральний директор SambaNova, розповів: «Ми також надаємо вам готові моделі, які можна налаштовувати, навчати та оптимізувати для широкомасштабного розгортання і виведення виробництва, що звільняє вас від потреби проводити ручне налаштування, вирівнювання та оптимізацію обладнання».

Модель Samba-1 складається з понад 50 моделей ШІ, які були індивідуально навчені й оптимізовані для спільної роботи. Серед них моделі від SambaNova, а також моделі з відкритим вихідним кодом, призначені для вирішення конкретних завдань підприємства, таких як Llama 2, Mistral, DeepSeek Coder, Falcon, DePlot, CLIP та Llava.

«Ми обрали краще з кращого. Ми визначили, які з них найкраще підходять для підприємств, а потім об’єднали їх і оптимізували у єдину модель з 1 трильйоном параметрів», — сказав Лян.

Лян пояснив, що різні моделі окремих компонентів можуть взаємодіяти між собою всередині Samba-1, таким чином, результат від однієї моделі може стати вхідними даними для наступної.

Підхід Composition of Experts відрізняється від підходу Mixture of Experts, який пропонують деякі LLM, такі як Mistral.

«Composition of Experts» передбачає, що одна експертна модель навчається на кількох наборах даних, що може призвести до просочення даних з одного набору в інший, порушуючи безпеку та конфіденційність. Натомість у Composition of Experts кожна експертна модель навчається окремо на своєму власному захищеному наборі даних, що забезпечує вищий рівень безпеки.

Підхід SambaNova дозволяє клієнтам навчати моделі на власних приватних даних і розгортати їх у власному середовищі. Це дозволяє підприємствам створювати власні, оптимізовані для їхнього бізнесу активи.

)

)

)

)

)

)

)