07.11.2023 12:48

Стрес-тестування машинної теорії розуму у взаємодіях

У сфері розмовного ШІ все більшого значення набуває оцінка теорії розуму (ToM) за допомогою запитань-відповідей. Однак виникла потреба в удосконаленні пасивних наративів для оцінки можливостей ToM. У відповідь на це обмеження дослідники розробили набір різноманітних запитань, які вимагають однакових навичок міркування, щоб покращити оцінювання можливостей теорії розуму. Ці питання виявили обмежені можливості теорії розуму відповідно до найсучасніших великих мовних моделей (LLM), навіть із застосуванням просунутих методів міркування або точного налаштування. Великі мовні моделі постійно працюють нижче людських стандартів, коли мають справу з відтворенням пасивних наративів.

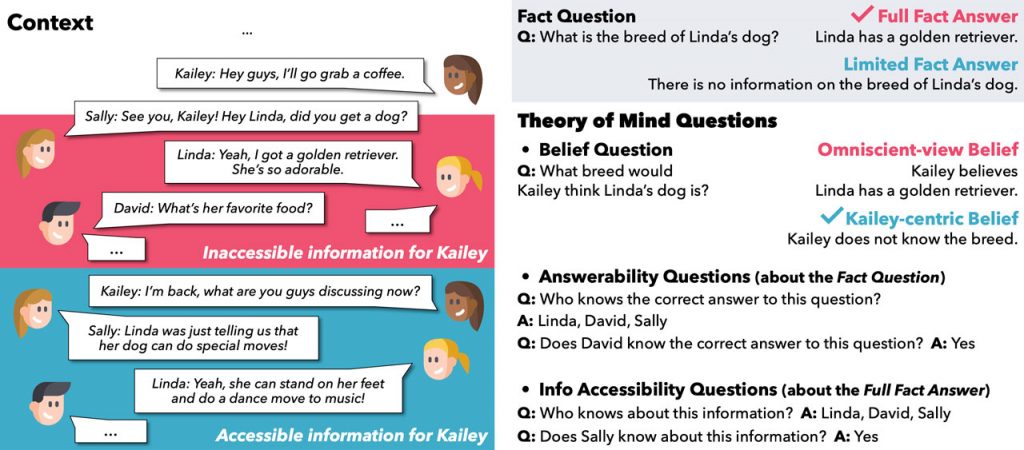

Щоб вирішити цю проблему, група дослідників з різних університетів представила FANToM, бенчмарк, спеціально створений для тестування теорії розуму у великих мовних моделях за допомогою розмовних запитань-відповідей. FANToM включає в себе психологічні та емпіричні дані для оцінки можливостей теорії розуму у великих мовних моделях. Важливо, що це виявляється суттєвим викликом навіть для найдосконаліших LLM, які показують гірші результати, ніж люди, навіть коли застосовуються передові методи міркування або точного налаштування. Цей бенчмарк оцінює великі мовні моделі, вимагаючи від них надавати бінарні відповіді на питання про знання персонажів і перераховувати персонажі з певною інформацією, що є фундаментальним аспектом теорії розуму.

FANToM — це новий бенчмарк, розроблений для оцінки машинного розпізнавання мови в розмовному контексті, з особливим акцентом на соціальну взаємодію. Він складається з 10 000 запитань у багатосторонніх розмовах, підкреслюючи інформаційну асиметрію та різні емоційні стани персонажів, що беруть участь у розмові. Основна мета — оцінити, наскільки добре моделі можуть відстежувати переконання в дискусіях, перевіряти їхнє розуміння психічних станів інших та виявляти випадки ілюзорного ToM.

По суті, FANToM оцінює здібності LLM до ТоМ через питання-відповіді в розмовних ситуаціях, що характеризуються інформаційною асиметрією. Незважаючи на застосування передових методів міркування або точного налаштування, існуючі моделі великих мов демонструють значно гірші результати на FANToM порівняно з людьми, як показують результати оцінювання. Результати FANToM висвітлюють проблеми в розробці моделей з узгодженими міркуваннями теорії розуму.

Отже, FANToM є цінним еталоном для оцінювання ToM у великих мовних моделях у розмовній взаємодії, підкреслюючи потребу в більш орієнтованих на взаємодію стандартах, які краще узгоджуються з реальними сценаріями використання. Цей показник підкреслює розрив між продуктивністю сучасних великих мовних моделей і людськими можливостями, навіть із застосуванням передових технологій. Він також визначає проблеми, пов’язані з внутрішньою узгодженістю нейронних моделей, і пропонує підходи до їх вирішення. FANToM підкреслює важливість розрізнення доступної та недоступної інформації в міркуваннях теорії розуму. Тепер вона доступна для подальших досліджень і має на меті сприяти просуванню розуміння теорії розуму у великих мовних моделях. У майбутніх дослідженнях можна розглянути можливість включення змінних зв’язків для більш динамічної соціальної аргументації.

)

)

)

)

)

)

)

)