01.09.2023 16:45

Кількісний закон для розуміння обробки даних у глибоких нейронних мережах

Загадковість штучного інтелекту, особливо в складній сфері глибокого навчання, вже тривалий час викликає цікавість. Ці складні нейронні мережі з їхніми прихованими шарами та заплутаними процесами одночасно зачаровують і спантеличують дослідників і практиків, приховуючи свої внутрішні механізми. Однак нещодавній прорив обіцяє розгадати цю загадку.

Група дослідників на чолі з Хангфенг Хе та Вейдзі Су представила революційний емпіричний закон, відомий як “закон рівновіддаленості”. Цей закон дає безпрецедентне розуміння структурованого хаосу, який розгортається під час навчання глибоких нейронних мереж, демістифікуючи процес навчання і пропонуючи цінну інформацію про дизайн архітектури, надійність моделі та інтерпретацію прогнозів.

Проблема полягає у складності, притаманній глибоким нейронним мережам. Завдяки численним шарам і взаємопов’язаним вузлам ці моделі виконують складні перетворення даних, які часто здаються хаотичними і непередбачуваними. Ця складність створила нагальну потребу в глибшому розумінні їхньої внутрішньої роботи, що перешкоджає прогресу в розробці архітектури та інтерпретації рішень, особливо в критично важливих додатках.

Емпіричний закон рівновіддаленості прорізає цей видимий хаос, розкриваючи глибинний порядок у глибинних нейронних мережах. По суті, закон кількісно визначає, як ці мережі класифікують дані на основі приналежності до класів на різних рівнях. Він виявляє послідовну закономірність: Розділення даних послідовно покращується з геометричною прогресією в межах кожного шару. Це ставить під сумнів уявлення про навчання як про бурхливий процес, висвітлюючи натомість структуровану і передбачувану подорож через шари мережі.

Цей емпіричний закон встановлює кількісну залежність: Нечіткість розділення для кожного шару зазнає геометричного покращення з постійною швидкістю. Коли дані проходять через кожен шар, закон забезпечує поступове посилення розділення між окремими класами. Важливо, що цей закон справедливий для різних мережевих архітектур і наборів даних, забезпечуючи фундаментальну основу, яка збагачує наше розуміння поведінки глибокого навчання. Формула, що визначає нечіткість розділення, виглядає наступним чином:

D(l)=ρ^l * D(0)

Тут D(l) означає нечіткість розділення для l-го шару, ρ — коефіцієнт затухання, а D(0) — нечіткість розділення на початковому шарі.

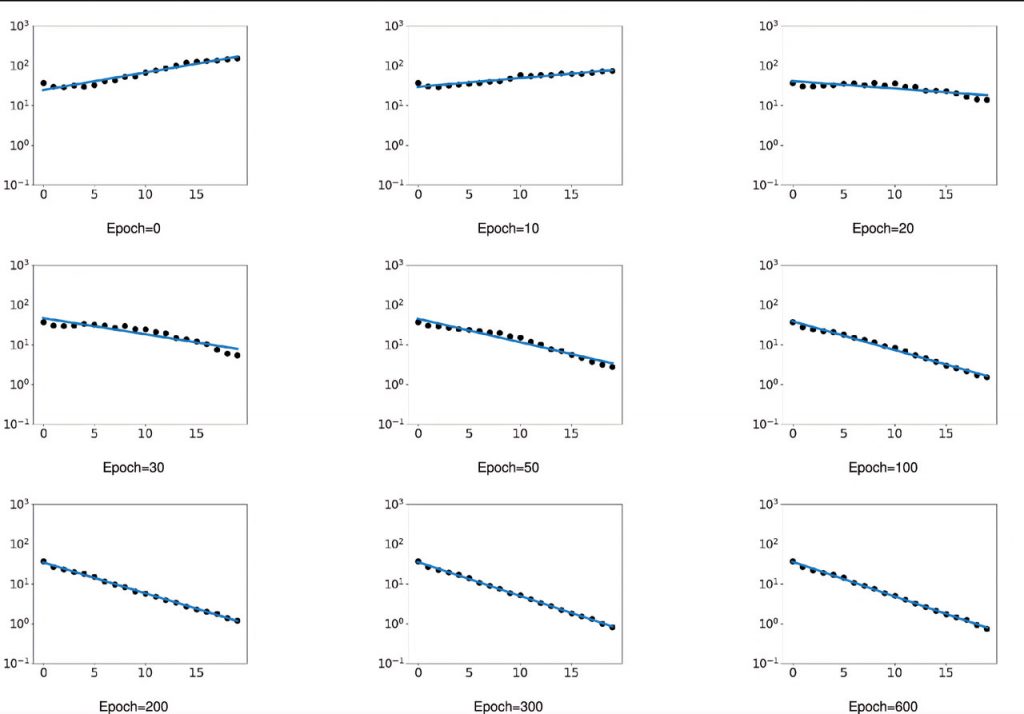

20-шарову нейронну мережу прямого поширення було навчено на наборі даних Fashion-MNIST, і було зроблено варте уваги відкриття. “Закон рівновіддаленості” почав проявлятися приблизно в епоху 100. На візуалізації вісь х представляє індекс шару, а вісь у — нечіткість розділення.

Це відкриття має значні наслідки. Традиційне глибоке навчання часто покладалося на евристики і техніки, що іноді призводило до неоптимальних результатів або ресурсоємних обчислень. Закон рівновіддаленості є керівним принципом для архітектурного дизайну, який передбачає, що мережі повинні володіти глибиною для досягнення оптимальної продуктивності. Однак, він також припускає, що надмірно глибокі мережі можуть приносити меншу віддачу.

Крім того, вплив цього закону поширюється на стратегії навчання та стійкість моделі. Його поява під час навчання узгоджується з покращенням продуктивності та стійкості моделі. Мережі, які дотримуються цього закону, демонструють більшу стійкість до збурень, що підвищує їхню надійність у реальних сценаріях. Ця стійкість безпосередньо випливає з організованого процесу розділення даних, описаного в законі, що підвищує здатність мережі узагальнювати дані, які виходять за межі її навчальних даних.

Інтерпретація моделей глибокого навчання постійно викликає труднощі через їхню природу “чорної скриньки”, що обмежує їхню застосовність у критичних контекстах прийняття рішень. Закон рівновіддаленості пропонує свіжий погляд на інтерпретацію. Кожен рівень мережі функціонує як модуль, роблячи рівномірний внесок у процес класифікації. Ця перспектива кидає виклик традиційному пошаровому аналізу і підкреслює важливість врахування колективної поведінки всіх шарів мережі.

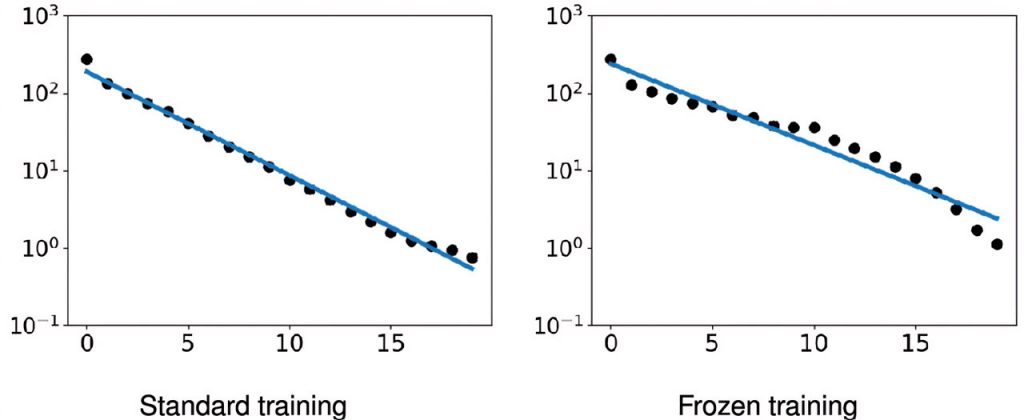

Ліва мережа, на відміну від замороженої правої мережі, яскраво демонструє закон рівновіддаленості. Незважаючи на те, що ліва мережа демонструє однакову ефективність навчання, вона має значно вищу точність тесту (23,85% порівняно з 19,67% у правій мережі).

Таким чином, емпіричний закон рівновіддаленості являє собою революційний прорив у сфері глибокого навчання. Він докорінно змінює наше уявлення про глибокі нейронні мережі, перетворюючи їх із загадкових чорних ящиків на добре організовані системи, керовані передбачуваним і геометрично структурованим процесом. Поки дослідники і практики намагаються розібратися в тонкощах архітектури, стратегій навчання та інтерпретації моделей, цей закон стає керівним принципом, готовим розкрити весь потенціал глибокого навчання в безлічі сфер. У світі, де прозорість і розуміння ШІ мають першорядне значення, закон рівновіддаленості сяє як провідна зірка, освітлюючи складні шляхи глибоких нейронних мереж.

)

)

)

)

)

)

)

)