26.08.2023 12:49

Швидкий і безпечний спосіб для отримання висновків LLM

Ландшафт штучного інтелекту зазнав трансформаційних змін завдяки появі великих мовних моделей (LLM). Поява ChatGPT стала каталізатором ери LLM і поштовхом до нового прогресу. Ці моделі, засновані на величезних масивах даних, продемонстрували свою майстерність, досягнувши успіху в розумінні мови і спростивши складні завдання.

З’явилися численні альтернативи ChatGPT, які прогресивно вдосконалюються з кожним днем і навіть перевершують ChatGPT у певних сферах. Такі моделі, як LLaMa, Claudia, Falcon та інші, готові кинути виклик верховенству ChatGPT.

Однак ChatGPT, безперечно, залишається найпоширенішим LLM. Швидше за все, ваш улюблений додаток на основі штучного інтелекту працює на базі ChatGPT. Однак, коли ми думаємо про безпеку, чи є це дійсно приватним і безпечним? OpenAI приділяє значну увагу захисту конфіденційності даних API, незважаючи на те, що одночасно стикається з юридичними проблемами. Незважаючи на зусилля, спрямовані на забезпечення конфіденційності та безпеки використання моделей, ці потужні моделі можуть виявитися складними для контролю.

Тож, як ми можемо використати потенціал LLM, не турбуючись про конфіденційність та безпеку? Як ми можемо використовувати можливості цих моделей, захищаючи при цьому конфіденційні дані?

PUMA представляє фреймворк, розроблений для забезпечення безпечної та ефективної оцінки моделей Transformer, зберігаючи при цьому цілісність даних. Інтегруючи безпечні багатосторонні обчислення (MPC) зі спрощеним висновком Transformer, PUMA вирішує цю проблему.

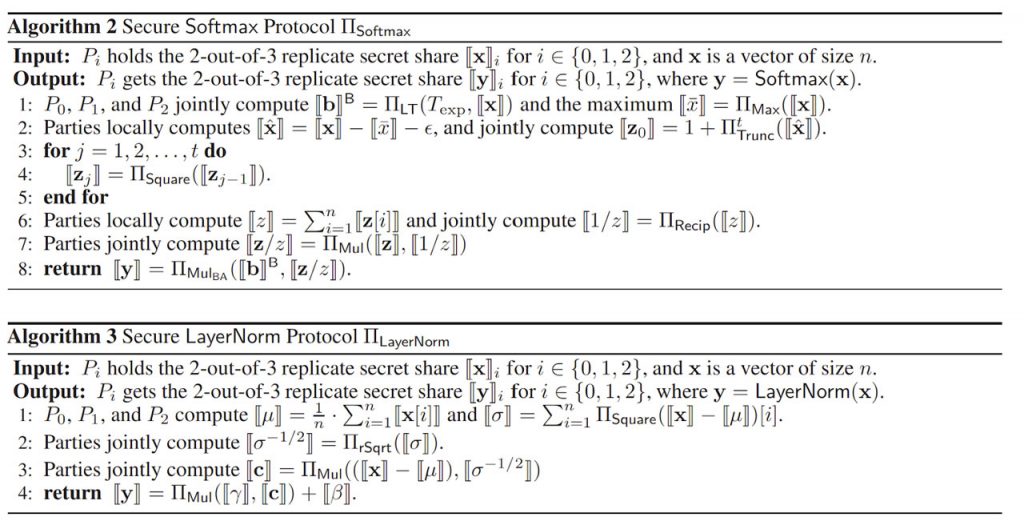

Основна інновація PUMA полягає в революційній технології апроксимації складних нелінійних функцій, присутніх у моделях Transformer, таких як GeLU і Softmax. Ці спеціальні апроксимації зберігають точність, водночас значно підвищуючи ефективність. На відміну від попередніх методів, які могли поставити під загрозу продуктивність або призвести до складних стратегій розгортання, PUMA забезпечує баланс між точністю та ефективністю, гарантуючи точний результат і задовольняючи вимоги реальних сценаріїв використання.

Центральне місце в PUMA займають три основні суб’єкти: власник моделі, клієнт і обчислювальна сторона. Кожен з них відіграє важливу роль у процесі безпечного виведення.

Власник моделі надає навчені моделі Transformer, тоді як клієнт надає вхідні дані і отримує результати виведення. Сторони спільно виконують протоколи безпечних обчислень, забезпечуючи захист даних і ваг моделей протягом усього процесу. Процес виведення PUMA ґрунтується на принципі дотримання конфіденційності вхідних даних і вагових коефіцієнтів, захищаючи конфіденційність усіх залучених суб’єктів.

Безпечне вбудовування, фундаментальний елемент безпечного виведення, зазвичай передбачає створення єдиного вектора з використанням ідентифікаторів токенів. Однак PUMA представляє дизайн безпечного вбудовування, який тісно пов’язаний зі стандартним робочим процесом моделей Transformer. Цей оптимізований підхід гарантує, що заходи безпеки легко інтегруються з архітектурою моделі, спрощуючи розгортання безпечних моделей у практичних додатках.

Значною перешкодою для безпечного висновку є апроксимація складних функцій, таких як GeLU і Softmax, таким чином, щоб досягти балансу між обчислювальною ефективністю і точністю. PUMA вирішує цю проблему шляхом створення більш точних апроксимацій, пристосованих до унікальних характеристик цих функцій. Використовуючи специфічні властивості GeLU і Softmax, PUMA помітно підвищує точність цих апроксимацій, одночасно оптимізуючи час виконання і накладні витрати на зв’язок.

LayerNorm, життєво важлива операція в моделі Transformer, створює певні проблеми в безпечному виведенні через формулу ділення на квадратний корінь. PUMA геніально вирішує цю проблему, перевизначаючи операцію LayerNorm за допомогою захищених протоколів, забезпечуючи безпечні та ефективні обчислення LayerNorm.

Видатним аспектом PUMA є її безшовна інтеграція. Фреймворк забезпечує наскрізний безпечний висновок для трансформаторних моделей, не вимагаючи значних модифікацій в архітектурі моделі. Це означає, що ви можете легко використовувати попередньо навчені Transformer-моделі з мінімальними труднощами. Незалежно від того, чи це мовна модель, отримана з Hugging Face, чи з іншої платформи, PUMA спрощує процес. Вона гармонійно поєднується з оригінальним робочим процесом і усуває необхідність у складному перенавчанні або складних змінах.

)

)

)

)

)

)

)

)