28.02.2024 14:33

EMO: Emote Portrait Alive, фреймворк для створення виразних портретних відео

В останні роки сфера створення зображень та відео розвивається на швидких кроках. Серед найновіших досягнень у цій галузі — EMO: Emote Portrait Alive, фреймворк, розроблений Інститутом інтелектуальних обчислень Alibaba Group.

EMO використовує модель дифузії audio2video для створення виразних портретних відео з надзвичайною реалістичністю і точністю. Завдяки використанню передових архітектур нейронних мереж, EMO розширює межі можливого у створенні відео з балакучою головою.

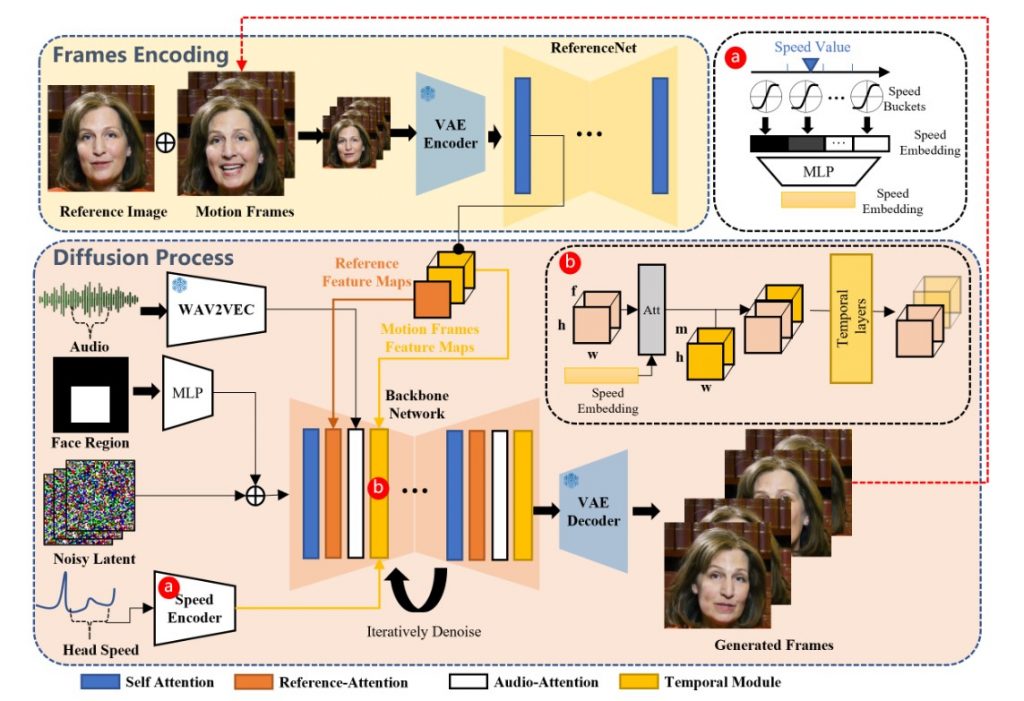

EMO — це двоетапний процес, який поєднує аудіо та візуальну інформацію для створення виразних портретних відео. Під час першого етапу, що називається кодуванням кадрів, нейронна мережа ReferenceNet аналізує особливості одного еталонного зображення і кадрів руху, створюючи основу для подальшого процесу дифузії.

На етапі дифузії EMO використовує попередньо навчений аудіокодер для обробки вбудовування звуку. Маска області обличчя інтегрується з багатокадровим шумом, що керує генерацією зображень обличчя. Опорна мережа, що включає механізми Reference-Attention та Audio-Attention, забезпечує збереження ідентичності персонажа та модулює його рухи. Також використовуються темпоральні модулі для маніпулювання часовим виміром і регулювання швидкості руху.

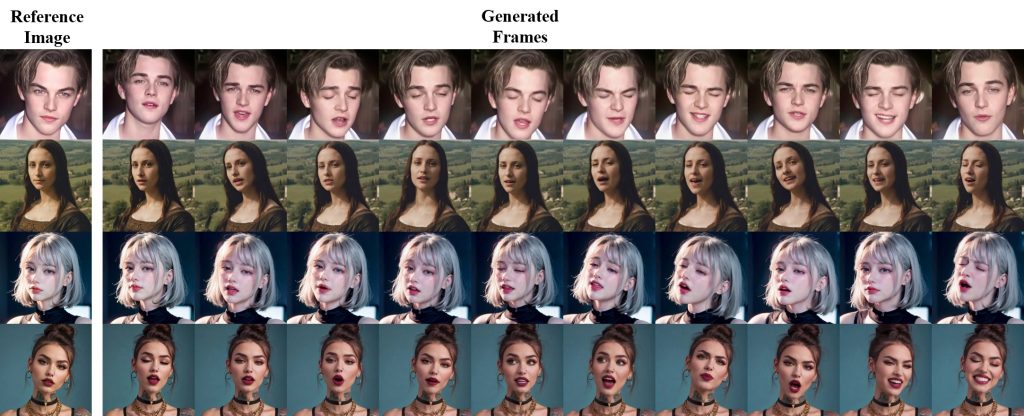

Поєднання цих технологій дозволяє EMO генерувати виразні розмовні та співочі відео з виразними обличчями та різноманітними положеннями голови. Фреймворк EMO також впроваджує концепцію генерації голосових аватарів, що розширює його можливості.

Однією з ключових переваг EMO є здатність підтримувати різні мови та стилі портретів. Він може генерувати аватари, що відображають культурні особливості різних мов та містять різноманітні емоції.

Хоча EMO показує вражаючі результати, є певні обмеження, які ще потрібно вирішити. Вдосконалення аудіовізуальної синхронізації та розпізнавання емоцій може подальше покращити реалістичність створених відео.

Нагадаємо, ByteDance представили DiffPortrait3D, нову модель умовної дифузії, призначену для створення фотореалістичних, 3D-послідовних зображень на основі одного натурного портрета.

)

)

)

)

)

)

)

)