13.08.2024 09:38

Нова архітектура ШІ Falcon Mamba 7B пропонує альтернативу моделям-трансформерам

Інститут технологічних інновацій (TII) з Абу-Дабі представив нову модель штучного інтелекту з відкритим кодом — Falcon Mamba 7B. Ця модель, доступна на платформі Hugging Face, пропонує потужну альтернативу чинним моделям-трансформерам завдяки новій архітектурі Mamba State Space Language Model (SSLM).

Falcon Mamba 7B здатна виконувати складні завдання з генерації тексту, перевершуючи інші моделі свого класу, зокрема Llama 3 8B, Llama 3.1 8B та Mistral 7B, у певних тестах. Це четверта модель з відкритим кодом від TII після Falcon 180B, Falcon 40B та Falcon 2, проте перша, що базується на архітектурі SSLM. Ця архітектура швидко здобуває популярність як потужна альтернатива традиційним трансформаторним моделям у сфері штучного інтелекту.

Інститут пропонує модель під ліцензією «Falcon License 2.0», заснованою на Apache 2.0, що дозволяє широке використання моделі. Моделі-трансформери залишаються домінантними у генеративному ШІ, але їх архітектура має певні недоліки при обробці довгих текстів, що вимагає значних обчислювальних ресурсів та пам’яті. Якщо ці ресурси не масштабуються належним чином, швидкість роботи моделі знижується, і вона може не впоратися з обробкою текстів, що перевищують певну довжину.

Архітектура мовних моделей простору станів, яка активно розвивається як альтернатива, пропонує розв’язання цієї проблеми. Вона безперервно оновлює «стан» моделі під час обробки слів, що дозволяє ефективніше працювати з довгими текстами. TII впровадив цю архітектуру у своїй новій моделі Falcon, яка базується на дослідженнях Університету Карнегі-Меллона та Принстонського університету.

Модель Falcon Mamba 7B використовує механізм вибору, який дозволяє динамічно налаштовувати параметри залежно від вхідних даних, подібно до механізму уваги в трансформаторах, але з можливістю обробки довших текстів. Це робить її ідеальною для завдань машинного перекладу, узагальнення текстів, комп’ютерного зору, обробки аудіо, а також оцінки та прогнозування.

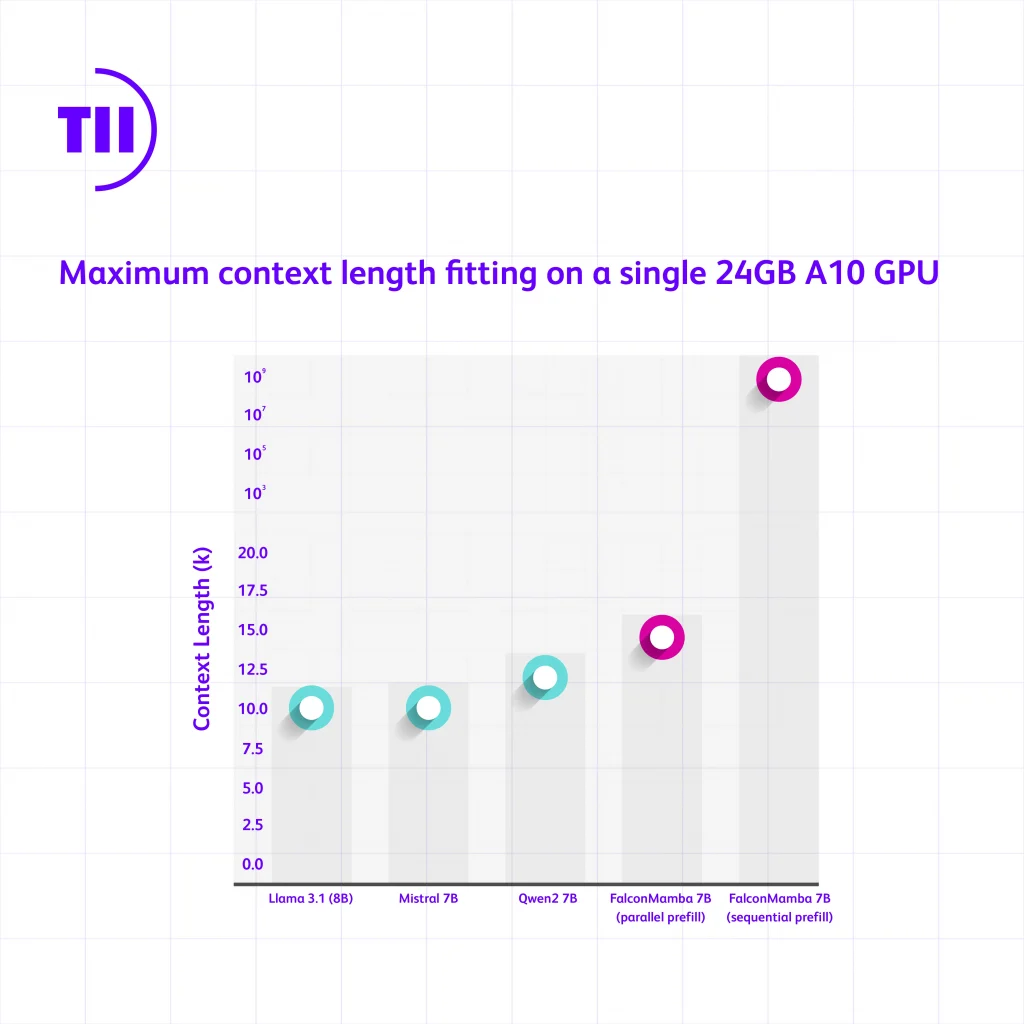

TII провів тестування Falcon Mamba 7B, щоб оцінити її продуктивність порівняно з провідними трансформаторними моделями того ж класу. Результати показали, що Falcon Mamba 7B може обробляти довші послідовності тексту та має потенціал обробляти нескінченну довжину контексту при послідовному обробленні токенів. У тесті на пропускну здатність модель перевершила навіть ефективну архітектуру Mistral 7B, генеруючи токени з постійною швидкістю та без збільшення пікової пам’яті.

У стандартних галузевих тестах Falcon Mamba 7B показала високу продуктивність, випередивши такі моделі, як Llama 3 8B та Mistral 7B, у тестах Arc, TruthfulQA та GSM8K. Однак у тестах MMLU та Hellaswag модель трохи відстала.

Це лише початок для Falcon Mamba 7B. TII планує подальшу оптимізацію моделі, щоб покращити її характеристики та розширити можливості застосування.

«Цей реліз відкриває нові горизонти та сприяє подальшому розвитку інтелектуальних систем. У TII ми прагнемо розширювати межі як SSLM, так і трансформаторних моделей, стимулюючи нові інновації у сфері генеративного ШІ», — зазначив д-р Хакім Хасід, виконуючий обов’язки головного наукового співробітника підрозділу TII зі штучного інтелекту.

Загалом, мовні моделі Falcon від TII були завантажені понад 45 мільйонів разів, що робить їх одними з найуспішніших релізів у сфері великих мовних моделей в ОАЕ.

)

)

)

)